我原先以為關於 Facebook「熱門話題」的新聞已經結束了,沒想到前幾天它又上演了續章。

在人工編輯團隊的「策展」引發操縱訊息的指控後,雖然 Facebook 的內部調查宣稱「查無不法」,但8月底(也就是距內部調查近三個月後)他們仍大刀砍掉了整個編輯團隊,並宣布將完全透過演算法來向用戶推送熱門新聞。

只是沒想到災難來得更快。透過演算法推送新聞才沒三天,用戶就收到了一則關於美國福斯新聞主播因支持希拉蕊而被開除的假新聞。此外,據其他新聞報導,Facebook 不僅推送了假新聞,還推薦了一個在Twitter上的不雅視訊。

從TechCrunch的內部消息來看,Facebook 推送熱門話題的標準可能僅僅基於與新聞話題相關的文章及貼文數量。如果這是真的,那這場災難恐怕一點也不令人意外。甚至,反而令人懷疑的是 Facebook 到底有多認真看待這個功能?

更值得延伸討論的是,Facebook 做出「裁撤編輯團隊並完全以演算法來推送新聞」這個決定的背後,反映出的一些觀點與問題。

簡言之,我們也許可以合理推測,雖然三個月前的內部調查宣稱查無不法,但 Facebook 恐怕認為問題就來自於編輯團隊的「人為」。因此,既然「人」不可信,他們便決定改讓「沒有偏見」的機器來推送新聞。

但問題在於機器(演算法)真的就沒有偏見嗎?甚至更深層的問題是,如今我們真的有辦法將人與機器的關係分得那麼清楚乾淨嗎?

由「誰」來決定不是問題所在

據上述TechCrunch同一則報導指出,Facebook 在大刀裁掉整個編輯團隊時,認為自己這麼做是為了讓熱門話題涉及的面向、傾向能夠更廣。這在我看來就是暗示:過去之所以有某些傾向的新聞被遮蔽,都是因為編輯人為造成的。而 Facebook 相信,改用演算法後,就能夠解決這個問題。

然而,演算法真的沒有偏見嗎?我們很容易認為,演算法這類被與電腦、機器歸類在一起的科技物就是「工具」。進而,當這些工具在運作時,不會像人一樣帶有主觀的情感與價值判斷。

例如,最熟悉的例子應該就是「抽籤」。如果是由「人」來選擇,那我們可能都不免會猜測這一選擇背後的動機與原因。但如果是透過抽籤,我們就往往會(很神奇地)覺得比較公平。這種把工具「中性化」的想像不難理解,但卻忽略了工具可能被「嵌入」人為的意向,甚至工具本身也有其特性會導致偏向。

過去我最常提到的例子,就是由美國建築大師Robert Moses於二十世紀初紐約長島蓋的「低架橋」。這些橋不僅是運輸的工具,也是區隔階級生活空間的裝置。

演算法也是如此。作為一種以「編碼」(code)為基礎的工具,它就是讓某些(計算)行動成為可能。例如,Facebook 就是透過演算法來決定哪些新聞是「熱門話題」。但是就像橋的高低會產生關鍵影響,演算法本身編寫的過程也可能被「嵌入」設計者的偏向。

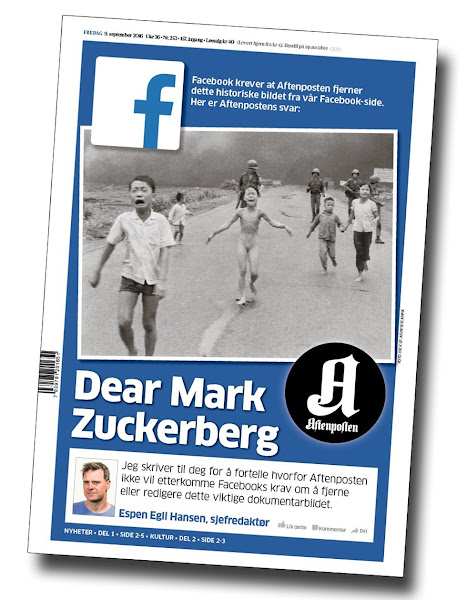

此外,由於演算法本身的特性在於計算,因此「量化」也就成了其內建的偏向。這意味著,它只能夠過各種「量」的──而非「質」的──資料來決定推送的新聞話題。這使得演算法無法像資深編輯者那般,透過內容品質來判斷是否該推送一則新聞。這幾天 Facebook 惹上的另一個麻煩也是如此,一張具有重要歷史意義的越戰新聞照片「燒夷彈女孩」被判斷為裸露照片而遭刪除。

這樣的問題其實在巨量資料的學術研究中,也造成極大困擾。也就是說,我們也許可以透過按讚、分享等數量來掌握使用者的行動,但卻無法宣稱理解了這些行動背後的意義與動機。這是科技特性的限制(偏向)使然。

因此,也許人作為編輯者總有其主觀意向與偏好,但要說演算法就是中立、客觀、無偏誤,恐怕不是醉了就是有滿滿的愛。如此一來,Facebook 裁掉大批編輯,改用演算法上工,與其說是解決問題,實際看來更像是捅出另一個大問題。

資訊時代的倫理判準?

不過,就如我剛剛說的,問題還是在於 Facebook 多認真看待這一功能?如果它只是著重於「熱門話題」的「熱門」,只是想吸引用戶的注意力的話,那似乎談什麼倫理問題也是多餘。

但如果 Facebook 確實認真將自己視為新聞傳播的重要媒介,並想要解決傳播上的偏向、甚至極化的問題的話,那麼關鍵不在於到底該由「人」還是「機器」來決定推送什麼新聞,而在於我們在這個資訊時代該採取什麼樣的倫理判準?

我在〈媒介該為我們做道德判斷嗎?〉一文中,曾經就 Facebook 操控訊息爭議事件提出相關的討論。當時,我藉由被稱為Google哲學家的Luciano Floridi的論點指出: Facebook 不應為使用者預先做道德判斷,也就是預先判斷哪些新聞話題是「好的」、值得用戶閱讀的。

當時我沒有說完的是:不為使用者預做道德判斷,不代表作為新聞傳播平台沒有任何倫理判準。進而言之,訴諸演算法「機器」的(虛假)中立性,在我看來也就完全不是一個負責的選擇。

可是,一個不預做道德判斷的倫理判準,這看起來似乎矛盾的要求是可能的嗎?也就是說,如果如Floridi所主張的,就算是不好的新聞(或搜尋結果)也不應該被移除,那麼這樣的新聞傳播背後就似乎沒有判準可言──只要是新聞就能被傳播。反過來,如果我們堅持應該「管理」被傳播的資訊,那麼也意味著預先判斷了哪些新聞是好的、值得傳播的。如此一來,一個不預做道德判斷的倫理判準真的存在嗎?

解決這一矛盾的關鍵在於,我們必須從單一的真理觀跳出來,轉而以「多元性」作為判斷的準則。

「單一」的真理觀通常是我們認識事物的方式,也就是會認為事物的對錯、好壞是固定的,而我們可能(有時則是必須)透過「共識」來進行判斷。換言之,所謂好的、對的,多半時候就等於社會多數人認為是好的、對的。然而,義大利哲學家Gianni Vattimo點出一個困境,也就是隨著現代社會越來越複雜、多元,人們之間的關係越來越超越時空地交織在一起,「共識」不僅越來越不可能,尋求共識本身可能也成了另一種隱性壓迫的來源。他因此主張,如今「多元性」可能更適合作為我們判斷事物的準則。

多元性作為一種判準的意思,並不是相對主義式的「都可以」。如果是後者,其實是變成沒有任何標準,而其導向的不是各說各話就是「看誰聲音(或拳頭)大」。Vattimo主張,之所以將「多元性」設定為判斷事物的準則,就是要抵抗任何違反多元性的主張或行動。

回過頭來,以「多元性」為判準,一個傳播新聞資訊的平台就能夠檢視自身所傳遞的訊息到底是堅持讓多元發聲,還是以「都是新聞」為名行侵犯與壓迫之實。而無論是誰(人或機器)來檢視,Facebook (或所有新聞傳播平台)該思考的是如何實踐此一多元性判準。

本文授權載自:數位時代